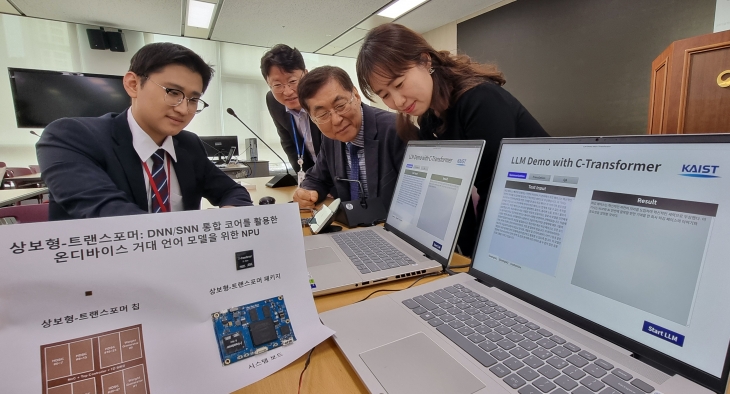

인간 뇌 구조와 기능을 모방한 원리로 전력 소모를 최소화하면서도 초고속으로 거대언어모델(LLM)을 처리할 수 있는 인공지능(AI) 반도체를 국내 연구진이 세계 최초로 개발했다고 6일 과학기술정보통신부가 밝혔다. 사진은 이날 정부세종청사 과기부에서 한국과학기술원(카이스트) PIM반도체 연구센터와 인공지능반도체대학원 유회준(오른쪽 2번째) 교수와 김상엽(맨 왼쪽) 박사가 시연하는 모습. 2024.3.6 연합뉴스

한국과학기술원(카이스트) PIM반도체 연구센터와 인공지능반도체대학원 유회준 교수 연구팀은 이 같은 초저전력 반도체 ‘상보형 트랜스포머’를 삼성전자 28㎚(나노미터) 공정을 통해 개발했다고 6일 과학기술정보통신부가 밝혔다.

연구팀은 그동안 다량의 GPU와 250W(와트)의 전력 소모를 통해 구동되던 GPT 2를 가로·세로 4.5㎜ 크기의 AI 반도체 한 개로 400㎽(밀리와트) 전력만 소모하면서 0.4초 만에 처리했다. 이번 연구 결과는 지난달 19∼23일 미국 샌프란시스코에서 열린 국제고체회로설계학회(ISSCC)에서 발표·시연됐다.

상보형 트랜스포머란 뇌의 뉴런이 정보를 처리하는 방식을 모사한 ‘스파이킹 뉴럴 네트워크’(SNN)와 여러 신경망 층으로 이뤄져 복잡한 패턴을 인식하고 학습하는 AI 모델인 ‘심층인공신경망’(DNN)을 선택적으로 사용할 수 있도록 한 기술이다. 생각할 것이 많을 때는 에너지 소모가 많고, 생각할 것이 적을 때는 에너지 소모가 적은 사람의 뇌 작동 원리를 AI반도체 형태로 구현했다. 입력값 크기가 클 때는 DNN을, 입력값이 작을 때는 SNN을 사용해 전력 소모를 최소화했다.

유회준 교수는 “뉴로모픽(뇌 기능 모사 기술) 컴퓨팅은 IBM, 인텔 같은 회사들도 의미 있게 구현하지 못한 기술로, 초저전력 뉴로모픽 가속기(상보형 트랜스포머)로 LLM을 구동한 것은 저희가 세계 최초라고 자부한다”고 말했다.

다만 당장 상용화로 이어질 수 있는 단계는 아니다. 연구팀은 향후 해당 기술을 LLM뿐 아니라 다양한 응용 분야로 확장해 연구하고, 상용화 관련 문제점들을 파악해 개선한다는 계획이다.